Diese letzte Abgabe für Grundlagen der Kommunikations und Medientherie beschäftigt sich mit den Problematiken des stark individualisierten Medienkonsums, i.e. Filterblasen bzw Echokammern. Die anderen Abgaben finden sich hier.

Material:

- Cass R. Sunstein: Republic.com 2.0, S. 1-45, Princeton 2007

- Eli Pariser: Videodokumentation, TED-Talk Beware online „filter bubbles“

AUFGABE 4.1

Was versteht Pariser unter dem Begriff „Filter-Bubble“ und wodurch kommt diese „Bubble” zustande? Erläutern Sie insbesondere auch, inwiefern nach Pariser die Filter Bubble ein Risiko für unseren Zugang zur Welt darstellt.

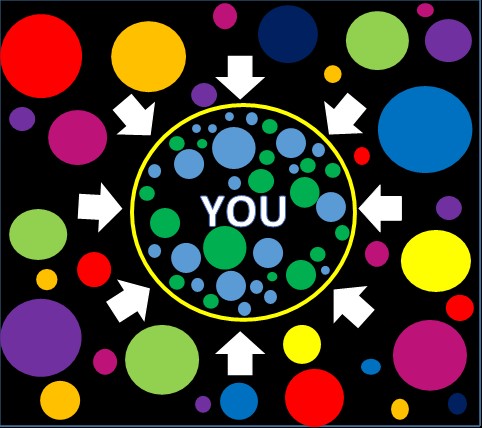

Mit “Filterblase” ist die all-umfassende beziehungsweise -durchdringende Personalisierung von Suchresultaten, Newsfeeds und Empfehlungen gemeint, die das Web prägt. Viele, vor allem viele der großen Internetplattformen setzen sehr stark auf die Profilierung der Nutzer*innen, um diesen primär beziehungsweise ausschließlich Inhalte anzuzeigen mit hoher “Relevanz” anzuzeigen, beispielsweise die für Nutzer*innen mit ähnlichem Profil interessant waren oder geografischen Bezug haben. Um Mark Zuckerberg zu zitieren [Übersetzung]: “Ein Eichhörnchen das vor dem eigenen Haus stirbt, kann relevanter für einen sein, als Menschen die in Afrika sterben.”

Im spezifischen stellt aber der Bezug auf “Menschen mit ähnlichen Interessen” ein Problem dar. Je nach ersten Klicks kann sich sehr schnell ein drastisch unterschiedlicher Feed ergeben. Divergierende Resultate beziehungsweise Meinungen verschwinden, wodurch sich diese Profile verhärten (siehe auch Echokammern weiter unten). Ein interessantes, vom “Blue Feed, Red Feed” im US-Wahlkampf inspiriertes Experiment aus der österreichischen Bundespräsidentschaftswahl 2016 findet sich hier. Im Zuge dessen wurden zwei neue Facebook-Profile angelegt, die jeweils einen der der beiden Kandidaten like-ten und davon ausgehend (Details im Artikel) weitere Seiten geliked, mit stark unterschiedlichem Feed als Resultat (e.g. “Asylwerber rettet fünfjähriges Kind” im Vergleich zu “Afghane randaliert in Spital” kommentiert mit “Aber so was von schnell in Handschellen ab nach Kabul! Stopp dem Asylwahnsinn!")

Dabei ist es meistens nicht klar, dass und in welcher Form diese Filterung stattfindet – herausgefilterte Inhalte bleiben unbekannt, ein mitunter großer Teil der Meinungsspektren verschwindet jenseits der persönlichen Filterblase. Als Resultat bekommen unterschiedliche Menschen auch drastisch unterschiedliche Ausschnitte des (Welt)geschehens zu sehen. Pariser bringt als Beispiel Screenshots zweier Freunde zur Google-Suchanfrage “Ägypten” die in einem Fall die Entwicklungen im Arabischen Frühling thematisieren und im anderen ausschließlich Touristischer Natur sind, sozusagen die politischen Entwicklungen ausblenden. Das Problem wird dabei noch dadurch verstärkt, dass die Blase an sich unsichtbar ist, da die wenigsten mitbekommen wie unterschiedlich die Resultate anderer Menschen sind.

Pariser beklagt dabei im spezifischen auch den Mangel an Möglichkeiten diese Filter-Algorithmen zu kontrollieren als Nutzer*in. Mehr dazu auch noch in 4.2b, da Sunstone im Kontrast dazu das Problem explizit bei den Konsumpräferenzen der Menschen verortet. Eric Schmidt, der CEO von Google meint dazu auch, dass [übersetzt] “es sehr schwer für Menschen sein wird, etwas zu anzusehen oder zu konsumieren, dass nicht in irgendeiner Form auf sie zugeschnitten ist.”

Als möglichen Lösungsansatz schlägt er vor, sich analog zur journalistischen Ethik im klassischen Sinne eine solche für algorithmische Redaktion (siehe auch 4.5 bezüglich menschlicher versus algorithmischer Gate-Keeper) zu etablieren. Im spezifischen sieht er als gute Redaktion eine gute Mischung zu geben zwischen den kurzfristigen Gratifikationen, i.e. dem was die Menschen suchen / sehen wollen (e.g. Cat-Content, “die vierte Wiederholung von Ace Ventura”) und dem was sie sehen sollten: e.g. wichtige politische Entwicklungen, Hochkultur, Selbstentwicklung, vor allem aber Dingen die wichtig wenn auch unbequem und in-Frage-stellend sind und Dinge aus anderen Blickwinkeln beleuchten.

Ein weiterer solcher Lösungsansatz wäre seiner Meinung nach erhöhter Kontrolle durch Nutzer*innen über die Filterblase (siehe 4.2b im Kontrast zu Sunstone)

AUFGABE 4.2a

a) Was versteht Sunstone unter dem Begriff „Echo Chamber“ (Echokammer)?

Sunstone sieht Echo-Kammern als Resultat der Personalisierung von Inhalten als digitale Realisierung einer Abwandlung von Negropontes “Daily Me”, einem persönlich zusammengestellten Kommunikationspaket, dessen Inhalte von Menschen im Voraus gewählt wurden, wodurch nur bewusst und aufgrund existierender Einstellungen gesuchte Erfahrungen und Meinungen enthalten sind. Im Falle der Personalisierung wird dieses Paket dabei von anderen Menschen und vor allem algorithmischen Systemen zusammengestellt, üblicherweise aufgrund Loggings des Nutzer*innenverhaltens und Empfehlung von Dingen die “Personen wie du” auch angeklickt, gekauft oder ähnliches haben (i.e. “Collaborative Filtering”)

Das führt dazu das von der eigenen divergierende Meinungen und Argumente nicht mehr wahrgenommen werden (e.g. da sie in Google Suchrankings oder im Facebook-Feed weiter hinten landen oder ganz ausgeblendet werden). Dies führt zu einem Rückgang von gesellschaftlichem Diskurs und Überlegung bei politischen Entscheidungen (siehe 4.3), sowie vor allem auch zur einer Bestätigung der eigenen Meinung durch wahrgenommenen Social Proof (i.e. – überspitzt – alle wahrgenommenen Meinungen, gar die öffentliche Meinung scheint der eigenen zu gleichen).

Dieses Rückspiegeln und Verstärken der eigenen Meinung, das daraus resultiert, ist dabei die Essenz der “Echo-Kammern”.

Dadurch ergibt sich auch eine verstärkte Fragmentierung der Gesellschaft in die verschiedenen Subgruppen, deren Meinungen sich intern gegenseitig verstärken, wodurch auch Extremismus leichter erwächst.

Als weitere Konsequenz ergeben sich dadurch auch Soziale Kaskaden – im spezifischen Cyber-Kaskaden – da populäre Inhalte und Argumente vergleichsweise noch zusätzlich verstärkte Verbreitung erhalten (unter Menschen, die mit diesem populärem Profil matchen), während davon abweichende Inhalte und Argumente nur schwer bis gar nicht eine breite Öffentlichkeit erreichen.

Im Sinne eines Lösungsansatzes argumentiert Sunstone stark für den Erhalt gemeinsamer Werte und Erfahrungen (als Teil der individuellen Werte und Erfahrungen) sowie eine Anpassung der Public Forum Doctrine auf moderne Gegebenheiten. Diese ist das Recht Straßen und Parks zu nutzen um Argumente und Beschwerden verbreiten zu können und dadurch sowohl die heterogene Bevölkerung zu erreichen, wie auch spezifische Personen und Organisationen (e.g. durch den Protest vor deren Büro). Dadurch können diese mit Erfahrungen und Argumenten in Kontakt kommen, die sie nicht bewusst aufgesucht hätten, beziehungsweise die sie auch bewusst vermeiden und ausblenden würden. Im klassischen Sinne gilt dieses Recht in den USA für Straßen und Parks, Sunstone argumentiert allerdings, dass es beispielsweise auf Flughäfen und “das Internet” (ich vermute vor allem große, redierende Plattformen wie etwa Facebook und Google) ausgeweitet werden soll. Dies wäre auch im Sinne einer gut funktionierenden, deliberativen Demokratie (siehe 4.3) von großer Bedeutung.

Sunstone nimmt dabei die Bürger*innen in die Pflicht, in dem er argumentiert, dass politische Souveränität gegebenenfalls Konsument*innen-Souveränität trumpft. Daher, dass diese als Teil einer deliberativen Demokratie (siehe 4.3) sowohl das Recht als auch die Pflicht haben kontrastierende Blickwinkel und Argumente auszudrücken aber vor allem auch zu bemerken/erfahren, statt ausschließlich im Sinne der Konsum-Freiheit (“die Kund*in ist König*in”) absolut bestimmen zu können welche Kommunikationsprodukte sie konsumieren.

AUFGABE 4.2b

b) Vergleichen Sie die Begriffe „Echo Chamber“ von Sunstein und „Filter-Bubble“ von Pariser. Arbeiten Sie die Ähnlichkeiten/Gemeinsamkeiten heraus und falls vorhanden auch die Unterschiede.

Beide Teilen eine große Ähnlichkeit – wie bereits in 4.1 und 4.2a ausführlich behandelt, stellen sie Mechanismen dar, die von der eigenen abweichende Meinungen ausblenden und durch eine Feedback-Schleife dazu führen, dass gesellschaftlichen Wirklichkeiten immer weiter divergieren, gegeneinander abgrenzen und verhärten – und damit auch die Gesellschaft fragmentiert und Extreme ausbilden. Beide führen das jeweilige Phänomen zumindest auf die gegenwärtige Verwendung algorithmischer Systeme, im spezifischen automatischer Personalisierung zurück. Beide argumentieren als Lösungsansatz dafür, dass Menschen – zu einem Teil – auch von der eigenen abweichende Meinungen zu Gesicht bekommen sollten. Pariser argumentiert dies über journalistische Ethik für algorithmische Redaktion (siehe 4.1), Sunstone über politische Souveränität (siehe 4.2a) – wobei ersterer dabei eher die Filterbetreiber*innen in die Pflicht nimmt und zweiterer eher die Bürger*innen. Sunstone sieht deren Bedürfnisse als den Ursprung der Problematik der Echokammern, da die Personalisierung sozusagen eine Idealform des Informationskonsums darstellt im Sinne der Konsumentent*innen-Souveränität. In diesem Sinn konfliktiert er zu einem gewissen Grad auch mit Parisers Lösungsansatz Nutzer*innen mehr Kontrolle über die Filter zu geben – liegt Sunstone hier richtig, sollte das keinen nennenswerten positiven Effekt auf die Problematik haben, wenn sie nicht gar verschlimmert würde.

AUFGABE 4.3

Erläutern Sie, wie Sunstein die Republik als Staatsform sowohl von der Monarchie als auch von der direkten Demokratie abgrenzt. Insbesondere: Wie begründet er, dass die amerikanische Verfassung eine Republik und keine direkte Demokratie vorsieht? Erläutern Sie weiters, inwiefern „Deliberation“ (Überlegung/Erwägung) eine Voraussetzung für informierte und reflektierte Entscheidungen in einer Demokratie ist und weshalb der Zugang zu und die Konfrontation mit heterogenen Informationen dafür erforderlich ist.

Gegenüber der Monarchie grenzt Sunstone die Republik ab als selbst-verwaltete Regierungsform (“We the People…” im Verfassungstext), gegenüber der direkten Demokratie oder auch populistischer Regierungsformen dadurch, dass die Regierungsmitglieder nicht direkt (potentiell wenig reflektierte), öffentliche Meinungen umsetzen, sondern überlegt und gut informiert diskutieren, abwägen und entscheiden – sozusagen als “Filter der Vernunft” zwischen der öffentlichen Meinung und dem Gesetzestext agieren und für diese Entscheidungen auch Verantwortung übernehmen. Im Blick auf die direkte Demokratie hat Sunstone hier die Besorgnis, dass sie (beziehungsweise eine wenig durchdachte Form?) im Sinne der “Deliberation” weniger abwägt und reflektiert und damit den Problemen, gegen die diese vorbeugen soll verstärkt aufsitzt. Im spezifischen erwähnt er einen vorgeschlagenen aber abgelehnten Teil der Bill of Rights, der Bürger*innen das Recht gegeben hätte Abgeordneten Abstimmungsverhalten zu diktieren. Senator Roger Shermans Hauptargument dagegen war, dass es eines der Grundprinzipien der Republik untergraben hätte und die Sinnhaftigkeit legislativer Treffen und Diskussionen und damit die “Deliberation” (Überlegung/Erwägung) untergraben hätte. Regulativ-Mechaniken im Regierungssystem der Vereinigten Staaten, wie beispielsweise das Zwei-Kammern System und das Electorate College, wurden in diesem Geist geschaffen um “Deliberation” zu fördern.

Für diese “Deliberation” (Überlegung/Erwägung) bei Regierungsentscheidungen, ist es wichtig, dass die Beteiligten gut informiert sind, reflektieren, möglichst ohne Eigeninteresse (im engeren Sinne) agieren und Blickpunkte und Argumente von Menschen verschiedenster Hintergründe einbeziehen. Dies hat das Ziel den Effekt kurzfristiger Meinungsschwankungen, Vorurteile, Biases und Mangel an Informationen zu minimieren und zu kreativeren, dem Allgemeinwohl dienlicheren Lösungen zu finden. Dabei ist zu bemerkten, dass selbst bei seiner Argumentation für die repräsentative Demokratie, Sunstone auch betont, dass besagter Diskurs auch in der Bevölkerung stattfinden sollte – er spricht dabei von den Pflichten der idealisierten Bürger*in als Teil, der in 4.2 bereits erwähnten politischen Souveränität. In diesem Sinne auch das auf Dollar-Noten aufgedruckte Motto “E Pluribus Unum” (“aus vielen, eines”) als Erinnerung.

Im Besonderen die wichtige Voraussetzung der Einbeziehungen heterogener Blickpunkte leidet allerdings unter den Echokammern (siehe 4.2) beziehungsweise Filterblasen (siehe 4.1). Speziell betont Sunstone dabei die Wichtigkeit, dass zumindest ein Teil der Werte und Erfahrungen von der gesamten Bevölkerung geteilt wird und argumentiert, dass dies beispielsweise einer der Beweggründe hinter der Bill of Rights ist.

AUFGABE 4.4

Übertragen Sie das, was Pariser und Sunstein für das Internet schildern, auf die personalisierten Recommendations von Amazon: Was sind hier die Konsequenzen? Gibt es auch da ein Risiko?

Für (E-)Books, Filme und Musik auf Amazon lassen sich relativ direkt die auf Nachrichten und Suchresultate fokussierten Beispiele von 4.1 bis 4.3 umlegen – daher, dass eher durch die Personalisierung der Suchresultate und Empfehlungen eher Medieninstanzen gefunden werden die Personen mit ähnlichem Surf- und Kaufverhalten interessant fanden, i.e. die zur eigenen ähnliche Meinungen und Weltanschauungen vertreten.

Bei diesen wie auch anderen Produkten ergibt sich allerdings auch die bisher im Spezifischen noch nicht angesprochene Problematik, dass Stereotypen und Abgrenzungen von Konsument*innen-Segmenten verstärkt werden. So genügt es beispielsweise mit klassischen Geschlechts-Rollenbildern, i.e. Produkte für “Sie” zu kaufen, um primär andere solche vorgeschlagen zu bekommen, während Produkte, die eher einem klassisch-männlichen Rollenbild zugeschrieben werden herausgefiltert werden. Dadurch verstärken sich besagte Rollenbilder. Es ist leicht vorzustellen, dass ähnliches auch für andere Stereotypisierungen gilt, e.g. Ethnizität, Ausbildung, Bevölkerungsschichten, Subkulturen, etc. Wie auch in den allgemeinen Beispielen aus 4.1 und 4.2 ist es auch hier so, dass der erste Klick beziehungsweise Einkauf beginnt das Profil in eine dieser Schubladen zu bewegen.

Im Zweifelsfall ist allerdings zu sagen, dass die Empfehlungen auf Amazon allerdings oft auch in sehr pragmatischem Sinne etwas fragwürdig sind, e.g. schlägt es nach dem Kauf eines Staubsaugers eine Sammlung anderer Staubsauger vor, nach dem Kauf einer Kamera den Kauf weiterer Kameras, etc (vermutlich da es sich bei diesen um “verwandte Produkte” handelt).

AUFGABE 4.5:

Erläutern Sie, was Pariser damit meint, dass die Kontrolle über Informationen, welche die Menschen erhalten, zunehmend von „human gatekeepers“ auf „algorithmic gatekeepers“ übergeht. Gehen Sie dabei insbesondere auch darauf ein, wie Pariser diesen Übergang bewertet und was die Gründe für seine Einschätzung sind.

Mit “Human Gatekeepers” sind hier klassische Medienorganisationen, wie beispielsweise Zeitungsredaktionen gemeint, die auswählen worüber und wie berichtet wird, und die vielbesagte vierte Säule des demokratischen Staates darstellen. Um verfälschenden sowie manipulativen Praktiken entgegenzuhalten, hat sich, beginnend in den 1910ern, ein Kodex journalistischer Ethik entwickelt.

Pariser berichtet dabei, dass mit Aufkommen des Internets oft der Wegfall dieser menschlichen Einflussnahmequelle verkündet wurde, aber sich in Wirklichkeit die redaktionelle Praxis lediglich zu algorithmischen Systemen in Form von Suchmaschinen und Recommendern hin verschoben hat, den “Algorithmic Gatekeepers”. Aus dieser Dichotomie zwischen Wahrnehmung und Realität ergibt sich auch, dass die in 4.1 thematisierte (algorithmisch bedingte) Filterblase wenig bemerkt wird und dass Algorithmen als “neutral”, “objektiv” und “unbiased” gelten.

Diese Wahrnehmungsdichotomie, sowie die Filterblasen kritisiert Pariser auch in seinem TED-Talk ausführlich und argumentiert für die Inklusion dessen, das Menschen “sehen sollten” in die Menge aus Dingen, die sie (kurzfristig/bewusst) “sehen wollen” – beziehungsweise von denen die Filteralgorithmen urteilen, dass sie sehen wollten. Er kritisiert dabei auch die Feedback-Schleife dieses Filters, der dazu führt, dass das eigene Profil sehr schnell kippen kann [übersetzt]: “von den ersten Klicks hängt es ab ob mensch eine balancierte Informationsdiät bekommt oder Informations-Junkfood.” Er bemängelt weiters, dass Nutzer*innen wenig bis gar keine Kontrolle über diese Algorithmic Gatekeepers haben.

AUFGABE 4.6:

Beschreiben und argumentieren Sie einen persönlichen Denkansatz zur Lösung oder Minimierung des in Aufgabe 4.5 beschriebenen Problems

Die in 4.1 und 4.2b bereits beschriebenen Ansätze von Pariser waren hier journalistische Ethik für Algorithmic Gatekeepers, mehr Kontrolle über Filter sowie Untermischung, von dem was Menschen sehen sollten unter dem was (Algorithmen berechnen, dass) sie sehen wollen.

Sunstone argumentiert, dass es die Pflicht der “deliberativen”/“erwägendenden” Regierung aber auch ihrer Bürger*innen ist sich (bis zu einem gewissen Grad) heterogenen Meinungen und Argumenten auszusetzen, genauso wie es ein Recht ist mit diesen die Allgemeinheit aber auch spezifische Personen und Organisationen zu erreichen. Als solches argumentiert Sunstone für eine Ausweitung der “Public Forum Doctrine” auf e.g. Flughäfen und das Internet (siehe 4.2 und 4.3 für Details).

In Kombination der beiden Forderungen wäre es auf Seiten der Filterbetreibenden wichtig bewusst Inhalte von Menschen mit orthogonalen/divergierenden Meinungen in Suchresultate und Empfehlungen zu inkludieren, sozusagen als “Mal was anderes”/“Erweitere deinen Horizont”-Kategorie.

Extrapolierend von Sunstones Argument der Bürger*innen-Pflichten könnte es sinnvoll sein Filterblasen/Echokammern im Unterricht beziehungsweise in Mainstream-Medien zu thematisieren (wie das teils bereits geschieht im Kontext der jüngsten Wahlen) und nahezulegen bewusst auch Quellen heranzuziehen, die eine höhere Chance auf unerwartete und fordernde Inhalte haben, als Beispiel regelmäßig auch andere (Online-)Zeitungen zu lesen, in ungewohnte Lokale zu gehen und sich mit anderen Gästen dort zu unterhalten, generell andere (Sub-)Kulturen und deren Argumentationen/Beschwerden kennen zu lernen, etc. Im selben Sinne ist es vermutlich sinnvoll nicht nur die Filterblasen-/Echokammer-Thematik anzusprechen, sondern auch die der Algorithmic Biases.

Parisers Forderung nach journalistischer Ethik für Algorithmic Gatekeepers könnte entweder als (überprüfbare?) Selbstverpflichtung großer Plattformbetreiber aktualisiert werden oder zeitverzögert über entsprechende Thematisierung/Lehre an den Universitäten. Für erstere Selbstverpflichtung kann es auch wichtig sein, dass Forschung bezüglich guter Beurteilungskriterien betrieben wird.

Neben dem bloßen Appell an diese Organisationen/Einrichtung/Bürger*innen könnten auch Steuermittel herangezogen werden, um bewusst aufklärerische Medienarbeit zu leisten oder auch finanzielle Anreize für entsprechende Projekte und Umsetzungen in Unternehmen zu schaffen. Ein punitiver Ansatz ist grundsätzlich zwar auch andenkbar, dürfte aber an (zumindest scheinbar) schwierig juristisch hieb- und stichfest machbarer Messbarkeit scheitern.